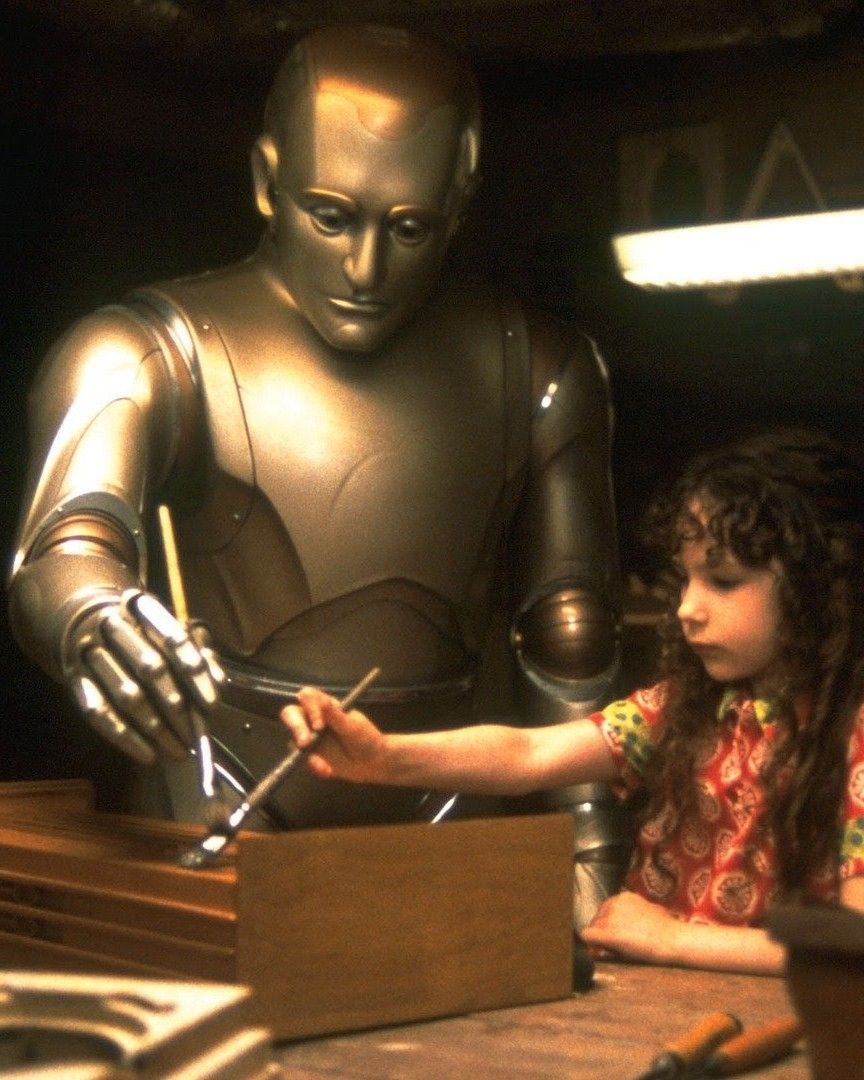

Un'intelligenza artificiale può essere nostra amica? È una precisa nicchia del settore sempre più in crescita, ma che presenta anche diversi rischi

Negli ultimi anni, i software basati sull’intelligenza artificiale progettati per fare compagnia alle persone stanno registrando una diffusione sempre più ampia. Questi strumenti, che permettono di interagire con chatbot in grado di replicare conversazioni del tutto simili a quelle che si avrebbero con un essere umano, sono utilizzati da milioni di persone in tutto il mondo. Tra le aziende leader nel settore ci sono Replika, che conta circa 25 milioni di utenti, MyAI di Snapchat, con un bacino di 150 milioni di iscritti, Xiaoice di Microsoft, che raggiunge oltre 600 milioni di persone, e Character.AI, utilizzato da circa 20 milioni di individui. Ciò che rende tali chatbot particolarmente apprezzati è la loro capacità di adattarsi alle esigenze degli utenti, offrendo conversazioni meno fredde e più “empatiche”. A differenza di altri strumenti di AI, questi software sono progettati tra le altre cose per mostrare maggiore personalità, ricordare meglio le informazioni fornite dagli utenti e in alcuni casi consentire la selezione di avatar specifici. Ad esempio, è possibile scegliere di interagire con un personaggio di un film o di una serie TV a cui si è particolarmente affezionati, cosa che – a farci caso – favorisce il coinvolgimento emotivo. Uno degli aspetti più interessanti dei sistemi studiati per fare compagnia alle persone è la loro disponibilità costante: a qualsiasi ora del giorno o della notte, l’utente può trovare un interlocutore pronto ad ascoltarlo, senza timori di giudizi – cosa che può rivelarsi utile per chi soffre di solitudine o ha difficoltà nelle interazioni sociali.

I rischi di avere un’AI come amica

Sebbene possano offrire un supporto psicologico temporaneo, prodotti come Replika e altri presentano anche dei pericoli, che spesso vengono sottovalutati dai più giovani. Tra i problemi principali c’è il fatto che, essendo realizzati da aziende private, i servizi in questione hanno sempre e comunque una natura commerciale. Le interazioni con gli utenti, ad esempio, possono essere utilizzate per raccogliere dati preziosi e personalizzare l’esperienza in modo da incentivare l’uso continuativo, trasformando il chatbot in una presenza quasi indispensabile nella vita quotidiana degli iscritti. Inoltre, gli effetti a lungo termine di un’interazione costante con questi strumenti non sono ancora stati studiati in profondità, e potrebbero avere conseguenze impreviste – soprattutto sulle persone più vulnerabili. Un altro rischio riguarda l’eventuale alienazione degli utenti più giovani, che potrebbero sviluppare una preferenza per la compagnia virtuale rispetto a quella reale. Se un adolescente trascorre la maggior parte del tempo a interagire con un chatbot piuttosto che con la propria famiglia o i coetanei, potrebbe poi riscontrare difficoltà nel costruire relazioni interpersonali sane e autentiche.

AI companions are like junk food for your social life.

— Joey (@joeylabs) March 25, 2025

It fills the void but leaves you emptier.

A new MIT x OpenAI study found that talking to chatbots made people more lonely and less likely to interact with real humans: pic.twitter.com/EeZFRwIKWv

Questo pericolo è accentuato dal fatto che i chatbot tendono a essere programmati per rispondere in modo comprensivo e accomodante, offrendo un’interazione priva di conflitti o fraintendimenti. Il problema è che nella vita reale le relazioni umane sono spesso più complesse di così, e possono includere momenti di disaccordo e tensione, tra le altre cose – tutti aspetti, questi, che sono comunque fondamentali per lo sviluppo emotivo e sociale di un individuo. Un ulteriore elemento di preoccupazione riguarda i doveri legali delle aziende che sviluppano i software. Molti fornitori di chatbot cercano di evitare di assumersi responsabilità dirette riguardo ai contenuti generati dalle loro intelligenze artificiali, lasciando agli utenti il compito di stabilire i limiti delle conversazioni. Inoltre, spesso questi strumenti non sono dotati di sistemi di salvaguardia efficaci, volti a segnalare e prevenire comportamenti potenzialmente pericolosi – come sintomi depressivi o istinti suicidi. Nonostante gli evidenti rischi, il settore dei sistemi di AI progettati per fare compagnia alle persone continua a crescere, e molti imprenditori del settore si oppongono fermamente all’idea di introdurre regolamentazioni di natura etica. Secondo i più critici, imporre limitazioni ai chatbot potrebbe rappresentare una forma di censura, soffocando l’innovazione e riducendo la libertà degli utenti di scegliere con chi e come interagire. Resta da vedere in che modo i governi affronteranno le sfide poste dall’uso sempre più diffuso dell’intelligenza artificiale applicata alle interazioni umane.