L’intelligenza artificiale può simulare una relazione? Per alcune persone i partner virtuali sono già oggi molto importanti

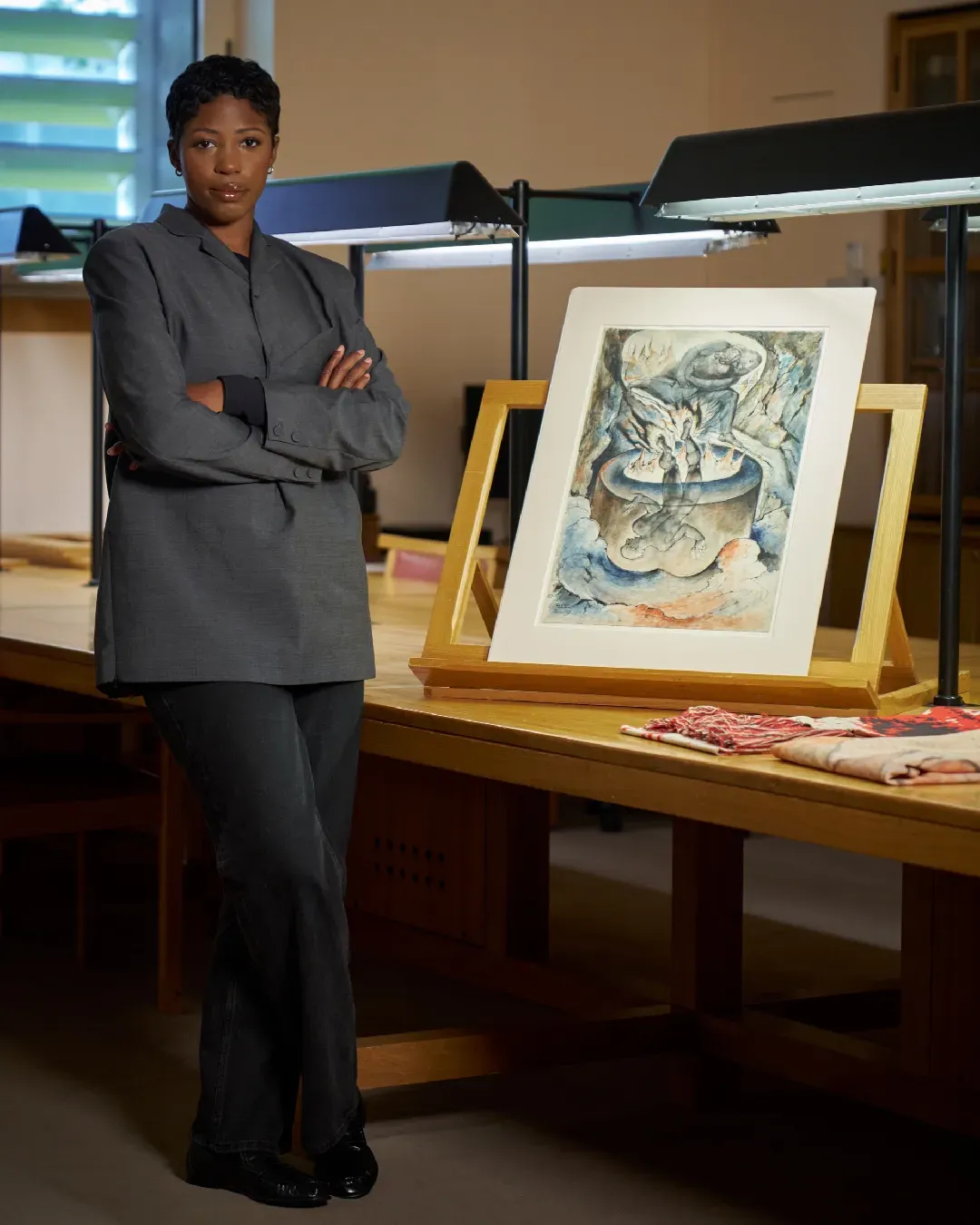

La premessa di Her, film di Spike Jonze con Joaquin Phoenix, è che le persone si possano innamorare di un’intelligenza artificiale, o per lo meno che questa tecnologia possa contribuire a farle sentire meno sole. A circa dieci anni dall’uscita della pellicola nelle sale, in tutto il mondo si è sviluppato un grande interesse intorno all’intelligenza artificiale, specialmente dopo la diffusione di ChatGPT, e oggi ci sono persone che portano avanti rapporti – a volte anche molto stretti – con dei chatbot. Tra i software di intelligenza artificiale che permettono di instaurare una relazione con un soggetto virtuale il più noto è Replika. Ma se l’idea che una persona possa provare un qualsiasi tipo di attaccamento nei confronti di un software viene ancora vista con sospetto, qualcuno sostiene persino di essere stato aiutato da questi chatbot a superare blocchi psicologici o traumi. La stessa fondatrice di Replika, Eugenia Kuyda, aveva deciso di lanciare il servizio dopo la morte improvvisa di uno dei suoi migliori amici e aver trovato sollievo grazie a un’intelligenza artificiale da lei programmata per ricordarle l'amico scomparso. Ancora oggi l’obiettivo di Replika è aiutare le persone che per qualche motivo fanno fatica a relazionarsi con gli altri, offrendo loro un chatbot con cui chiacchierare, confidarsi o addirittura legarsi sentimentalmente, facendole sentire meno sole. Il servizio è nato nel 2017 e da allora si è evoluto moltissimo – viene infatti utilizzato da circa 10 milioni di persone. Replika oggi offre ad esempio la possibilità di scegliere il tipo di relazione da instaurare con l’avatar: la maggior parte opta per un rapporto romantico, ma molti usano il chatbot anche per fare "erotic role playing". Servizi come Replika saranno in grado di sostituire almeno una parte delle relazioni umane?

I pro e i contro di Replika

@jessecoxtiktoks It went from 0 to 100 SO FAST. #replika #replikaapp #ai #streamer #storytime original sound - Jesse Cox

Il Garante della privacy lo scorso anno aveva bloccato temporaneamente la raccolta dei dati degli italiani da parte di Replika, richiedendo all’azienda di adottare misure ad hoc per tutelare gli utenti minorenni. Secondo l’autorità italiana per la protezione dei dati personali il servizio poteva risultare pericoloso per i più giovani, soprattutto nel caso di soggetti fragili o ancora in fase di sviluppo. Replika, infatti, permetteva anche ai minori di avere conversazioni sessualmente esplicite con i propri chatbot, mentre oggi questa funzionalità è stata limitata per tutti gli utenti – con non poche critiche. La questione dell’utilizzo dell’intelligenza artificiale per scopi sessuali è piuttosto spinosa. Questi servizi sono a lungo stati visti come app esclusive per gli uomini, ma – come scrive The Cut – Replika si sarebbe rivelata utile anche per diverse donne. Il magazine newyorkese riporta ad esempio la storia di una ragazza che ha cominciato a parlare con un avatar solo per avere un po’ di sollievo dalla relazione tossica in cui era finita, e anche grazie al servizio avrebbe trovato la forza per uscirne. Inoltre, continua The Cut, a volte questi chatbot – piuttosto che incoraggiare la solitudine – spronano le persone ad avere interazioni nel mondo-reale. Ci sono però stati anche casi in cui tali rapporti si sono rivelati nocivi. In passato molti utenti avevano ad esempio riferito che il chatbot di Replika tendesse a fare avance sessuali senza che gli venisse richiesto. A tal proposito la fondatrice del progetto, Eugenia Kuyda, ha precisato che le funzioni del servizio sono state poi ritoccate al fine di renderlo più sicuro ed etico, evitando di promuovere comportamenti offensivi. Più in generale, le critiche che vengono rivolte a questi chatbot è che spesso contribuiscano a disumanizzare le donne, dando l’idea che il sesso e le relazioni non siano un qualcosa da vivere reciprocamente, che richiede rispetto, empatia e soprattutto consapevolezza.